컨텐츠 내용

- 수강신청

- 과정정보

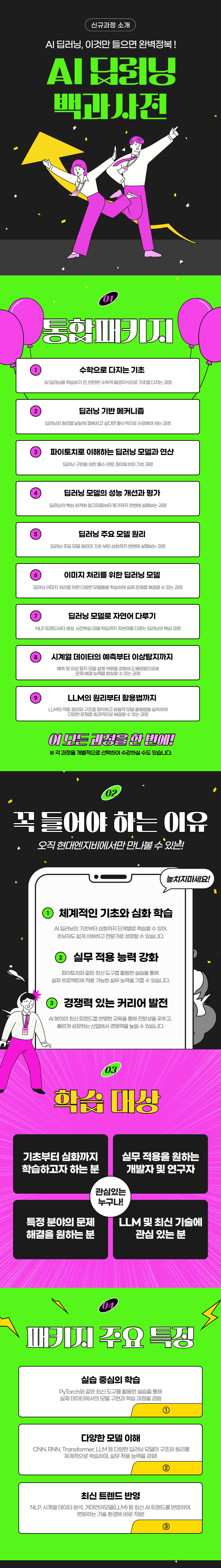

[AI 딥러닝 백과사전] 통합 패키지

학습목표

인공지능과 딥러닝 활용의 기반이 되는 핵심 개념 및 원리를 이해하고 주요 모델의 작동 방식을 설명할 수 있다.

※ 본 과정은 '통합 패키지' 입니다. 개별 과정 학습을 희망하시는 경우 별도 과정을 신청하여주시기 바랍니다.

※ 본 과정은 '통합 패키지' 입니다. 개별 과정 학습을 희망하시는 경우 별도 과정을 신청하여주시기 바랍니다.

교육대상

인공지능 및 딥러닝 분야 진입을 희망하는 초급 학습자

※ 본 과정 수강을 위해서는 대학수학 수준(함수, 미분, 확률과 통계 등)의 사전 지식이 필요합니다.

※ 본 과정 수강을 위해서는 대학수학 수준(함수, 미분, 확률과 통계 등)의 사전 지식이 필요합니다.

과정소개

수료기준

| 평가기준 | 진도율 | 총점 |

|---|---|---|

| 배점 | 100% | 100점 |

| 수료기준 | 80% | 80점 |

※ 수료기준은 각 평가항목의 점수가 수료기준 점수 이상이고 총점이 80점 이상이어야 합니다.

| 차시 | 강의명 |

|---|---|

| 수학으로 다지는 기초 | |

| 1차시 | [수학으로 다지는 기초] 단변수 함수의 미분과 근사 |

| 2차시 | [수학으로 다지는 기초] 다변수 함수의 미분 |

| 3차시 | [수학으로 다지는 기초] 확률 변수 |

| 4차시 | [수학으로 다지는 기초] 다양한 확률 분포 |

| 5차시 | [수학으로 다지는 기초] 다변수 확률 변수 |

| 6차시 | [수학으로 다지는 기초] 정보와 Entropy |

| 7차시 | [수학으로 다지는 기초] 다변수 확률 변수의 Entropy |

| 8차시 | [수학으로 다지는 기초] Mutual Information, Cross entropy, KL Divergence |

| 딥러닝 기반 메커니즘 | |

| 9차시 | [딥러닝 기반 메커니즘] Deep Learning Intro |

| 10차시 | [딥러닝 기반 메커니즘] Perceptron의 이해 |

| 11차시 | [딥러닝 기반 메커니즘] Multi-layer Perceptron과 Neural Network |

| 12차시 | [딥러닝 기반 메커니즘] Forward Propagation |

| 13차시 | [딥러닝 기반 메커니즘] Forward Propagation 예시 MNIST Classification Model |

| 14차시 | [딥러닝 기반 메커니즘] Softmax Classifier와 Logistic Regression |

| 15차시 | [딥러닝 기반 메커니즘] Backpropagation을 위한 수학적 배경 지식 |

| 16차시 | [딥러닝 기반 메커니즘] Backpropagation 1 |

| 17차시 | [딥러닝 기반 메커니즘] Backpropagation 2 |

| 18차시 | [딥러닝 기반 메커니즘] Linear Layer의 Backpropagation |

| 19차시 | [딥러닝 기반 메커니즘] Softmax Classifier 및 Logistic Regression의 Backpropagation |

| 파이토치로 이해하는 딥러닝 모델과 연산 | |

| 20차시 | [파이토치로 이해하는 딥러닝 모델과 연산] Pytorch Intro |

| 21차시 | [파이토치로 이해하는 딥러닝 모델과 연산] Pytorch Tensor Operation 1 |

| 22차시 | [파이토치로 이해하는 딥러닝 모델과 연산] Pytorch Tensor Operation 2 |

| 23차시 | [파이토치로 이해하는 딥러닝 모델과 연산] Forward, Backward Propagation, Autograd |

| 딥러닝 모델의 성능 개선과 평가 | |

| 24차시 | [딥러닝 모델의 성능 개선과 평가] Gradient Descent와 Learning Rate |

| 25차시 | [딥러닝 모델의 성능 개선과 평가] 변형된 Gradient Descent 방법들 (1) Momentum |

| 26차시 | [딥러닝 모델의 성능 개선과 평가] 변형된 Gradient Descent 방법들 (2) AdaGrad, RMSProp, Adam |

| 27차시 | [딥러닝 모델의 성능 개선과 평가] Activation Function |

| 28차시 | [딥러닝 모델의 성능 개선과 평가] Batch Normalization |

| 29차시 | [딥러닝 모델의 성능 개선과 평가] Dropout |

| 30차시 | [딥러닝 모델의 성능 개선과 평가] Data Augmentation |

| 31차시 | [딥러닝 모델의 성능 개선과 평가] Binary Classification Model의 평가 |

| 32차시 | [딥러닝 모델의 성능 개선과 평가] Multi-Class Classification Model의 평가 |

| 딥러닝 주요 모델 원리 | |

| 33차시 | [딥러닝 주요 모델 원리] Convolution 연산 |

| 34차시 | [딥러닝 주요 모델 원리] Stacking Convolution Layers |

| 35차시 | [딥러닝 주요 모델 원리] Convolutional Neural Network |

| 36차시 | [딥러닝 주요 모델 원리] RNN |

| 37차시 | [딥러닝 주요 모델 원리] Language Modeling |

| 38차시 | [딥러닝 주요 모델 원리] Seq2seq with Attention |

| 39차시 | [딥러닝 주요 모델 원리] Transformer 모델 (1) Self-Attention 1 |

| 40차시 | [딥러닝 주요 모델 원리] Transformer 모델 (1) Self-Attention 2 |

| 41차시 | [딥러닝 주요 모델 원리] Transformer 모델 (2) 기타 구성 요소 1 |

| 42차시 | [딥러닝 주요 모델 원리] Transformer 모델 (2) 기타 구성 요소 2 |

| 이미지 처리를 위한 딥러닝 모델 | |

| 43차시 | [이미지 처리를 위한 딥러닝 모델] CNN 모델 구조 1 |

| 44차시 | [이미지 처리를 위한 딥러닝 모델] CNN 모델 구조 2 |

| 45차시 | [이미지 처리를 위한 딥러닝 모델] CNN 모델 구조 3 |

| 46차시 | [이미지 처리를 위한 딥러닝 모델] Two-stage Object Detection |

| 47차시 | [이미지 처리를 위한 딥러닝 모델] Object Detection의 평가 방법 |

| 48차시 | [이미지 처리를 위한 딥러닝 모델] Single-Stage Object Detection |

| 딥러닝 모델로 자연어 다루기 | |

| 49차시 | [딥러닝 모델로 자연어 다루기] Tokenization |

| 50차시 | [딥러닝 모델로 자연어 다루기] Word Embedding |

| 51차시 | [딥러닝 모델로 자연어 다루기] Self-Supervised Pretrained Model 1 BERT |

| 52차시 | [딥러닝 모델로 자연어 다루기] Self-Supervised Pretrained Model 2 Generative Pretrained Transformer (GPT) |

| 53차시 | [딥러닝 모델로 자연어 다루기] Decoding을 통한 자연어 생성 |

| 54차시 | [딥러닝 모델로 자연어 다루기] Evaluation for Text Generation |

| 시계열 데이터의 예측부터 이상탐지까지 | |

| 55차시 | [시계열 데이터의 예측부터 이상탐지까지] 시계열 데이터 특성 및 처리 방법 |

| 56차시 | [시계열 데이터의 예측부터 이상탐지까지] 시계열 분해 기법 |

| 57차시 | [시계열 데이터의 예측부터 이상탐지까지] 시계열 예측 모델 1 |

| 58차시 | [시계열 데이터의 예측부터 이상탐지까지] 시계열 예측 모델 2 |

| 59차시 | [시계열 데이터의 예측부터 이상탐지까지] 시계열 이상 탐지 1 |

| 60차시 | [시계열 데이터의 예측부터 이상탐지까지] 시계열 이상 탐지 2 |

| LLM의 원리부터 활용법까지 | |

| 61차시 | [LLM의 원리부터 활용법까지] 거대언어모델 1 |

| 62차시 | [LLM의 원리부터 활용법까지] 거대언어모델 2 |

| 63차시 | [LLM의 원리부터 활용법까지] Alignment Tuning 1 |

| 64차시 | [LLM의 원리부터 활용법까지] Alignment Tuning 2 |

| 65차시 | [LLM의 원리부터 활용법까지] Alignment Tuning 3 |

| 66차시 | [LLM의 원리부터 활용법까지] Prompt Engineering 1 |

| 67차시 | [LLM의 원리부터 활용법까지] Prompt Engineering 2 |

| 68차시 | [LLM의 원리부터 활용법까지] Prompt Engineering 3 |

| 69차시 | [LLM의 원리부터 활용법까지] Prompt Engineering 4 |

| 70차시 | [LLM의 원리부터 활용법까지] Prompt Engineering 5 |